A crescente adoção de Large Language Models (LLMs) está impactando o mercado, todos profissionais de TI que não estivessem presos em uma caverna sem internet nestes últimos meses tendem a concordar com isso. No entanto, a combinação de múltiplos agentes baseados em LLMs levanta desafios únicos, e por sinal, bem complexos! No modelo tradicional de Machine Learning sempre validamos os modelos com métricas de avaliação de performance como a matriz de confusão, mas, como medir a eficiência desses sistemas de agentes ou multiagentes de LLM?

Avaliar um único LLM já exige métricas robustas, porém um sistema multiagente adiciona ainda mais camadas de complexidade. Cada agente pode desempenhar papéis diferentes, interagir de formas variadas e impactar o resultado final do sistema.

Quero explorar, e te apresentar, por que a medição é fundamental, além de comentar sobre os desafios envolvidos e as diferenças entre um LLM isolado e um sistema multiagente, como também, falar das principais métricas de avaliação formais e também dos métodos empíricos.

Por que medir a eficiência de sistemas multiagentes?

Medir o desempenho de sistemas multiagentes baseados em LLMs é peça importante para validar sua eficácia em aplicações reais. Diferente de um único modelo de linguagem, um sistema multiagente pode envolver diversos componentes colaborativos. Contudo, se não forem avaliados corretamente, esses sistemas podem apresentar problemas como redundância, latência e inconsistências nos resultados.

Outro fator crítico é a otimização de recursos computacionais. Sistemas multiagentes podem consumir alto poder computacional, demandando otimização para evitar desperdício de capacidade de processamento, e afinal, jogar dinheiro fora.

O impacto na experiência do usuário também é relevante. Chatbots avançados, assistentes de IA e automação de processos já usam sistemas multiagentes. Se a colaboração entre agentes não for fluida e eficaz, os usuários podem enfrentar respostas incoerentes, atrasos ou falhas no fluxo da interação. Além dos riscos que citei no finalzinho do primeiro parágrafo.

Desafios na avaliação de sistemas multiagentes

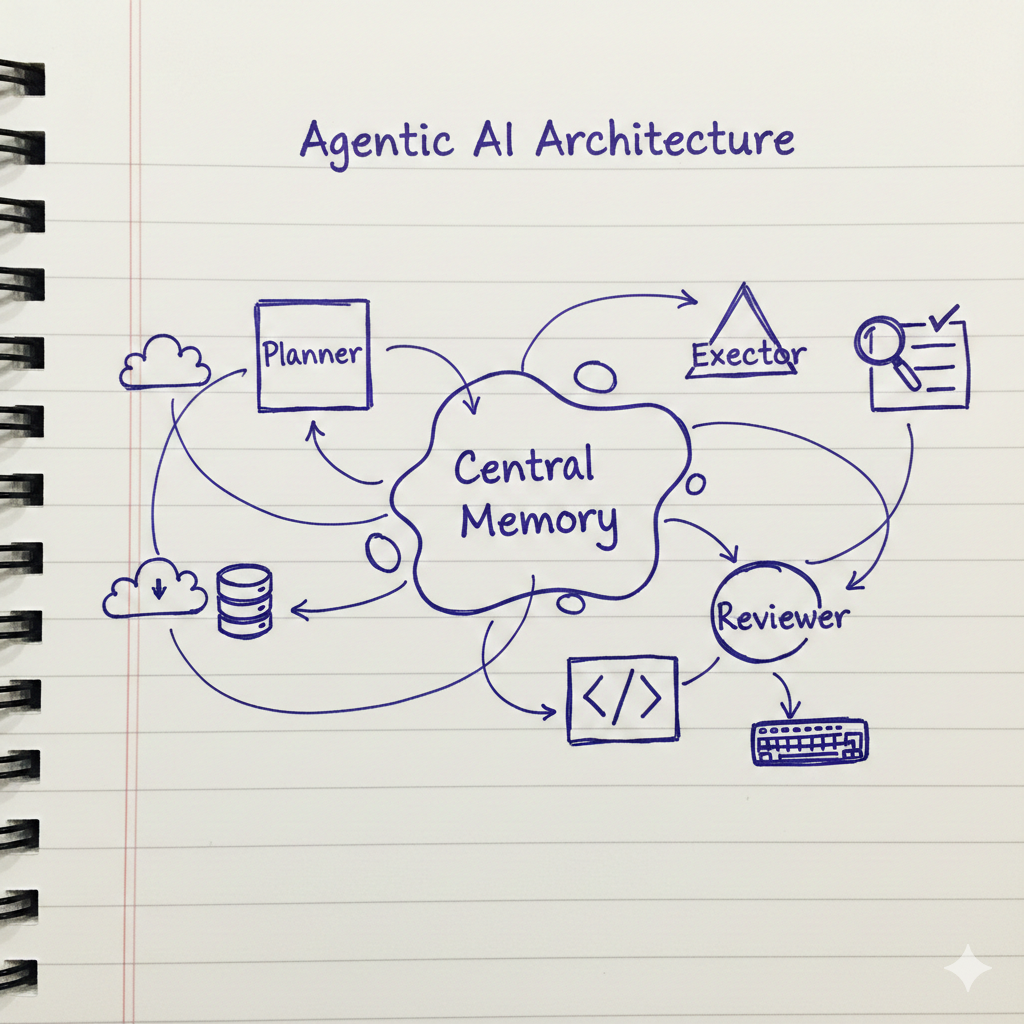

Um dos principais desafios é a complexidade das interações entre agentes. Ao contrário de um LLM isolado, um sistema multiagente precisa considerar não apenas a precisão das respostas, mas, também, a fluidez da comunicação entre os agentes. Existem várias estratégias que ajudam a criar sistemas multiagentes.

Outro desafio é a variabilidade dos cenários de teste. Diferentes aplicações exigem diferentes abordagens de avaliação. Por exemplo, a consistência das respostas e capacidade de adaptação ao contexto devem ser testados em sistemas voltados para atendimento ao cliente. Já agentes usados para geração de código precisam ser avaliados pela exatidão e eficiência na colaboração além de entregar código que compila.

A escalabilidade também é um ponto crítico, contudo, a medida que mais agentes são adicionados no fluxo, o desempenho pode ser impactado de maneiras imprevisíveis. Uma medição eficaz precisa metrificar como a escalabilidade afeta latência, uso de memória e qualidade das respostas.

Diferenças entre medir um único LLM e um sistema de multiagentes

A avaliação de um único LLM geralmente se concentra na precisão das respostas, fluência textual e eficiência computacional, contudo, deixa outras métricas de fora. Por exemplo, as métricas tradicionais incluem perplexidade, Bilingual Evaluation Understudy (BLEU) e Metric for Evaluation of Translation with Explicit Ordering (METEOR), que analisam a qualidade do texto gerado. No entanto, esses critérios não são suficientes para um sistema multiagente.

Em um sistema de agentes colaborativos, a interdependência entre agentes deve ser considerada. Isso significa que métricas como tempo de resposta em interações múltiplas, coerência global da conversa e resiliência a falhas se tornam mais importantes. Se um agente falha ou gera uma resposta inconsistente, a avaliação precisa medir como o sistema como um todo reage e compensa essas falhas.

Além disso, o comportamento emergente é um fator relevante. Em sistemas multiagentes, os agentes podem desenvolver padrões de interação que não foram necessariamente previstos. Garantir a adaptabilidade do sistema é essencial para assegurar que as respostas geradas sejam úteis e confiáveis.

Mas afinal, e as métricas de avaliação?!

Principais métricas para avaliação formal

Diferentes métricas são utilizadas para avaliação de sistemas multiagentes de LLM, contudo, algumas das mais relevantes são:

- Latência: Mede o tempo de resposta do sistema ao longo de múltiplas interações.

- Coerência conversacional: Avalia se as respostas entre diferentes agentes mantêm um fluxo lógico e coerente.

- Taxa de erro: Identifica falhas na comunicação e respostas inconsistentes geradas pelos agentes.

- Uso de recursos computacionais: Monitora a eficiência em termos de poder computacional, medindo consumo de CPU, GPU, memória, etc.

- Capacidade de Escalabilidade: Analisa como o desempenho do sistema se altera conforme novos agentes são adicionados.

- Resiliência: Avalia a capacidade do sistema de se adaptar a falhas de agentes individuais.

Métodos para avaliação empírica

As avaliações empíricas consistem principalmente em testes simulados e avaliações em ambientes reais, e em algumas situações pontuais, podem considerar benchmarks específicos de nicho.

Os testes simulados permitem modelar interações entre agentes em cenários controlados, entretanto, esses testes ajudam a identificar falhas antes da implementação prática.

Já a avaliação em ambiente real é usada para validar a aplicabilidade e integração do sistema. Testes com usuários reais, análise de feedback e monitoramento contínuo ajudam a garantir que o desempenho se mantem adequado ao longo do tempo.

Por fim, os benchmarks específicos de nicho oferecem comparações padronizadas entre diferentes soluções de vários outros sistemas, permitindo identificar os pontos fortes e fracos de cada abordagem, possibilitando comparar a avaliação de sistemas multiagentes de LLM que você está fazendo com outros sistemas do mesmo contexto.

Para encerrar

É fundamental lembrar que não existe uma única métrica mágica que resolva tudo! Você tem as métricas formais, como correspondência exata e distâncias de string, que são ótimas para obter medições claras e objetivas, especialmente quando você precisa verificar se uma resposta é factualmente correta ou quão próximos dois textos estão.

Depois, também tem as métricas empíricas, que mergulham nas coisas mais interpretativas, como o quão bem uma IA segue instruções, quão relevantes e coerentes são suas respostas e até mesmo se ela está usando linguagem tóxica.

Como estamos falando de sistemas multiagentes, você pode até mesmo colocar uma IA como jurada para fazer as coisas rapidamente. Mas mesmo assim, é importante estar ciente de que até os agentes de IA podem ter vieses e impactar seu projeto!

Para aprofundar nas coisas que escrevi no texto, recomendo a leitura do capítulo 12 do livro Generative AI on Google Cloud with LangChain; e o Capítulo 3 do livro AI Engineering;

Imagem de capa criada com Grok, a partir do prompt: “Gere uma imagem onde o Agente Smith do filme Matrix está fazendo uma avaliação em um tablet, ele está com expressão de preocupado. Utilize o cenário apropriado, destaque o rosto do agente e dê ênfase para a avaliação que ele está fazendo. Utilize estilo de ilustração digital de cartoon”