A história da Inteligência Artificial

IA da década de 40 até o Deep Learning

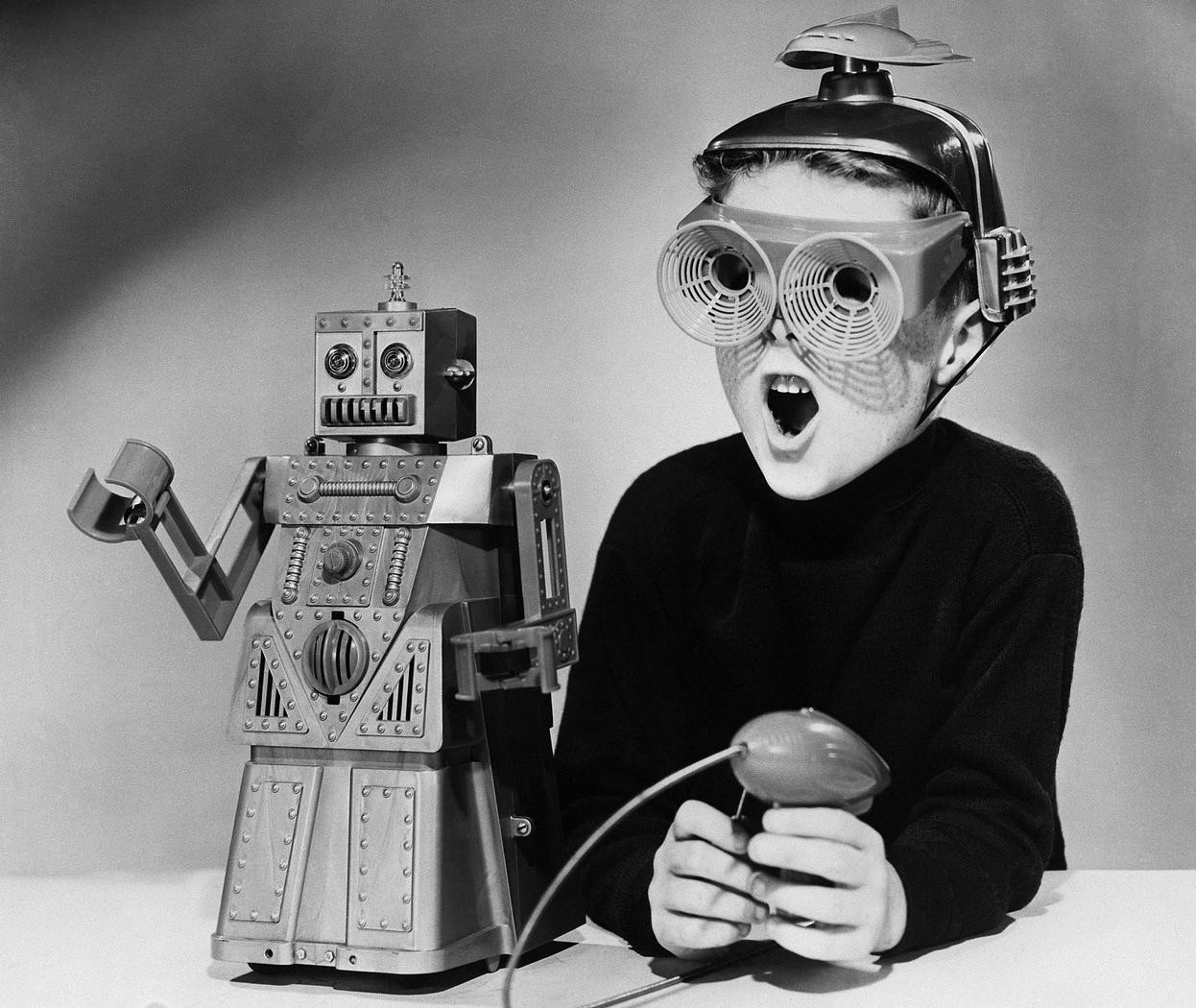

Muito se fala sobre a Inteligência Artificial hoje em dia, mas poucos lembram que ela começou há mais de 75 anos. Este levantamento navega por todo esse período, apresentando algumas tarefas de IA em cada período. Divirtam-se com a história da Inteligência Artificial.

Onde tudo começou

Pode-se dizer que a IA de fato começou há mais de 75 anos, com Walter Pitts e Warren McCulloch, em 1943. Eles juntaram a proposta de funcionamento do neurônio biológico do ganhador Nobel de Medicina Camillo Golgi, a lógica proposicional de Bertrand Russell e Alfred Whitehead e a Teoria da Computação, proposta por Alan Turing. Em 1943 os pesquisadores criaram um sistema neural artificial onde interpretaram sinais binários como ligado e desligado. Eles diziam que era possível representar funções matemáticas com uma certa combinação destes neurônios.

Pouco depois, em 1950, Marvin Minsk e Dean Edmonds construíram o primeiro computador neural, simulando o comportamento de 40 neurônios durante seus estudos em Harvard. Mais tarde, Minsk trocou Harvard por Princeton, onde defendeu seu doutorado.

Ainda em 1950 Alan Turing apresentou seu trabalho conhecido como Teste de Turing. O teste propunha a criação de um sistema de Inteligência Artificial capaz de responder questionamentos por escrito de um interrogador humano. O sistema de IA seria considerado satisfatório se o interrogador não conseguisse diferenciar quais respostas foram dadas pelo computador e quais foram respondidas por outro ser humano. Resultados positivos do teste começaram a aparecer só após anos 2000.

Em meados dos anos 1950 pesquisadores de diversas universidades dos EUA se juntaram e passaram por 2 meses estudando e propondo soluções para possíveis problemas. Estes pesquisadores foram fundamentais para a evolução da IA no mundo, posteriormente criando laboratórios de Inteligência Artificial em universidades como MIT, Stanford e Princeton.

Grandes avanços da Inteligência Artificial…

Em 1958, John McCarthy criou a linguagem LISP dentro do MIT. LISP foi a principal linguagem de programação para trabalhar com IA por pelo menos os 30 anos seguintes. Também em 1958 Frank Rosenblatt, que foi aluno do Minsk, propôs o Perceptron. Essa proposição gerou uma nova abordagem para se trabalhar com uma representação de redes neurais artificiais.

Em 1959 surgiram as primeiras implementações de algoritmos genéticos, que eram chamados de evolução automática naquela época. Seu propósito era implementar pequenas mutações nos sistemas e observar se havia melhora significativa. Os experimentos utilizaram mutações aleatórias e registraram os resultados pareciam úteis. Não houve muito sucesso com os experimentos realizados naquela época. Os algoritmos genéticos de hoje em dia são muito mais performáticos e funcionais.

Na década de 60 os primeiros sistemas inteligentes para tradução de texto começaram a tomar relevância. Fizeram isso, acima de tudo, para traduzirem conteúdos escritos em russo sobre o Sputnik, o Programa Espacial Russo. Mesmo assim, até aproximadamente 1966, os resultados não eram satisfatórios e os pesquisadores desacreditavam das possibilidades de tê-los funcionando.

No começo dos anos 1970 havia uma onda de pesquisa propondo o uso de elementos racionais mais simples para compor um elemento mais complexo, a abordagem ficou conhecida como Métodos Fracos ou IA Fraca. Apesar de serem gerais, contudo, não podiam se utilizar de métodos escalonáveis ou difíceis. Estas pesquisas abriram espaço para os conhecidos Sistemas Especialistas, que se propunham a resolver problemas específicos de forma muito satisfatória. Ao estender os sistemas especialistas para outras áreas do conhecimento, como por exemplo a área médica, foi percebida a necessidade de o sistema refletir também a incerteza do modelo. Foi então que se iniciaram avaliações de Fatores de Incerteza nas decisões que eram apresentadas pelo sistema de IA.

Quando as coisas começaram a se engrenar para a Inteligência Artificial

Ainda em meados da década de 70 os pesquisadores voltaram a investir tempo em sistemas de interpretação e linguagem natural, para habilitar a IA a trabalhar com tradução. Um esforço grande foi feito para entender a linguagem em si, e como era a construção da linguagem. Foram propostas algumas linguagens de programação para refletir essa ideia da representação de raciocínio e lógica, e talvez a mais famosa tenha sido a linguagem Prolog.

O início da década de 80 deu ainda mais ênfase aos sistemas especialistas, conseqüentemente grande parte das empresas dos Estados Unidos tinha um (ou algumas dezenas, podendo chegar a centenas) sistema especialista. Na segunda parte de 1980, as redes neurais voltaram a ter relevância nas pesquisas e no mercado. Existiam alguns grupos voltando a estudar a evolução do Perceptron de Múltiplas Camadas que havia sido proposto em 1969, porém desta vez com o uso de retro propagação. As coisas começaram a melhorar para essa área de pesquisa.

Em 1988 uma nova função de ativação para redes neurais foi sugerida, era uma função radial proposto por David Broomhead e David Lowe e ficou mundialmente conhecida com RBF – Radial Bases Function.

Já em 1998 um grupo de pesquisadores aplicaram técnicas de convolução em redes neurais de múltiplas camadas para extrair características de imagens. As possibilidades de uso dos dados não estruturados chegou a outro patamar! Então com a CNN (Convolutional Neural Network) foi dado início ao que é mais conhecido hoje em dia como Deep Learning.

Recomendação de leitura sobre IA

Se quiser saber mais sobre a história da Inteligência Artificial, recomendo o livro Artificial Intelligence: A Modern Approach, escrito por Peter Norvig e Stuart Russell. Uma distribuição da Microsoft, mas que tem oferta gratuita para uso, é o Azure Machine Learning.